Was sind Aktivierungsfunktionen?

Aktivierungsfunktionen sind mathematische Funktionen, welche die Ausgabe eines Neurons berechnen. Sie bringen Nichtlinearität in das Netzwerk, wodurch es in der Lage ist, schwerere Muster zu lernen. Ohne Aktivierungsfunktionen wäre ein Neurales Netzwerk nur in der Lage, lineare Muster zu lernen wie zum Beispiel den Preis von Fünf Äpfeln. Dadurch würde die Leistungsfähigkeit von einem Neuralen Netzwerk stark eingeschränkt und kann somit keine schweren Muster mehr lernen.

Warum sind Aktivierungsfunktionen wichtig?

Aktivierungsfunktionen sind das Herzstück eines Neuralen Netzwerks. Sie ermöglichen es dem Netzwerk, nichtlineare Zusammenhänge zwischen den Eingabedaten und den gewünschten Ausgaben zu lernen. Durch die Verwendung nichtlinearer Aktivierungsfunktionen kann das Netzwerk schwerere Muster, wie das Erkennen von Objekten in Bildern oder das Verständnis natürlicher Sprache, erlernen.

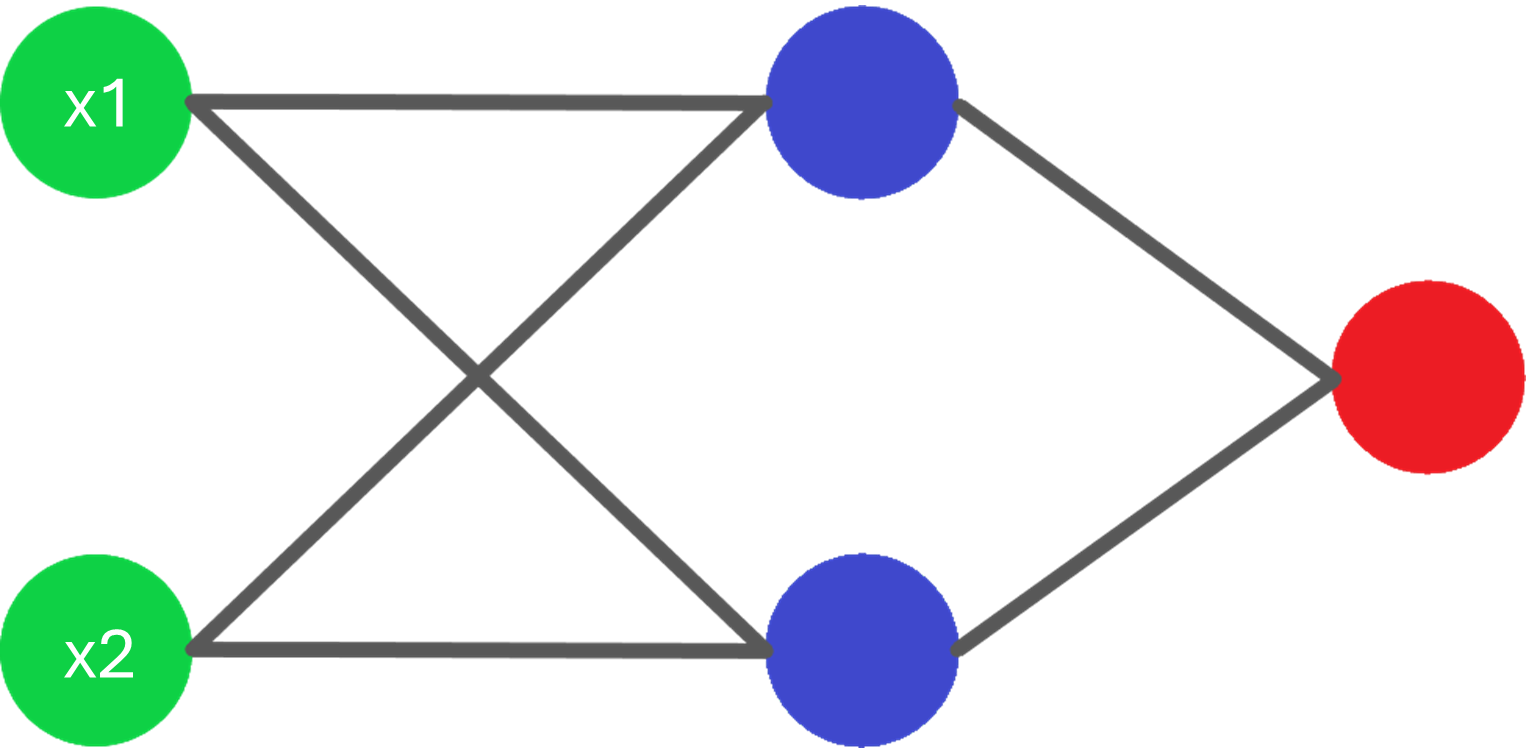

Verwendung in einem Neuralen Netzwerk

Aktivierungsfunktionen werden in einem Neuralen Netzwerk bei dem Vorhersageprozess und Trainingsprozess verwendet. Hierbei ist es wichtig zu beachten, dass in den beiden Prozessen die Aktivierungsfunktion nicht auf die gleiche Weise verwendet wird.

Aktivierungsfunktion im Vorhersageprozess

In dem Vorhersageprozess werden Aktivierungsfunktionen verwendet, um die Ausgabe eines Neurons zu berechnen. Hierbei bekommt die Aktivierungsfunktion einen Eingabewert, der davor berechnet wurde.

Dieser Berechnete Wert wird dann an eine Aktivierungsfunktion weitergegeben z.B. ReLU.

Hier ist die Formel für ReLU (Rectified linear unit):

Aktivierungsfunktion im Trainingsprozess

In dem Trainingsprozess werden Aktivierungsfunktionen verwendet, um die Steigung im Bezug auf den Fehler des Netzwerks zu berechnen. Um die Steigung der Aktivierungsfunktion zu bekommen wird die sogenannte Ableitung (Derivative) der Aktivierungsfunktion berechnet.

Hier ist die Formel für die Ableitung von ReLU:

Die Steigung der Aktivierungsfunktion ist ein wichtiger Bestandteil von dem Trainingsprozess. Sie zeigt dem Netzwerk, in welche Richtung (Positiv oder Negativ) ein Parameter Optimiert werden muss, um den Fehler zu verringern.

Liste mit Aktivierungsfunktionen

| Name | Funktion | Ableitung | Ausgabebereich |

|---|---|---|---|

| Identity | |||

| Binary step | |||

| Sigmoid | |||

| Hyperbolic tangent | |||

| Rectified linear unit | |||

| Softplus | |||

| Leaky rectified linear unit | |||

| Sigmoid linear unit | |||

| Gaussian |