Was sind Aktivierungsfunktionen?

Aktivierungsfunktionen sind mathematische Funktionen, die in Neuralen Netzwerken verwendet werden, um die Ausgabe eines Neurons zu bestimmen. Sie nehmen die Summe der gewichteten Eingaben eines Neurons (plus den Bias-Wert) und wandeln sie in einen Ausgabewert um, der an die nächste Schicht weitergegeben wird.

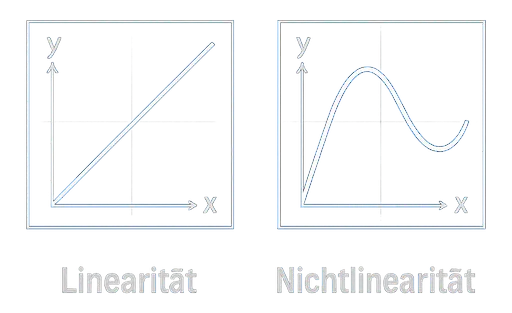

Der Hauptzweck von Aktivierungsfunktionen besteht darin, Nichtliniarität in das Netzwerk einzuführen. Ohne sie wären Neurale Netzwerke nur in der Lage, einfache Linien zu beschreiben, und könnten keine komplexen Muster in Daten erkennen.

Warum sind Aktivierungsfunktionen wichtig?

Aktivierungsfunktionen sind entscheidend, weil sie es dem Neuralen Netzwerk ermöglichen, komplexe Beziehungen in den Daten zu lernen. Ohne sie wäre ein Neurales Netzwerk auf einfache, lineare Zusammenhänge beschränkt und könnte keine anspruchsvollen Aufgaben wie Bilderkennung oder Sprachverarbeitung bewältigen.

Ein weiterer wichtiger Aspekt ist, dass Aktivierungsfunktionen die Ausgabe eines Neurons begrenzen. Zum Beispiel kann die Sigmoid-Funktion die Ausgabe auf einen Bereich zwischen 0 und 1 beschränken. Dies ist nützlich, um sicherzustellen, dass die Werte innerhalb eines bestimmten Bereichs bleiben, was für Aufgaben wie Klassifizierung wichtig ist.

Verwendung in einem Neuralen Netzwerk

Aktivierungsfunktionen werden in allen Schichten außer der Eingabeschicht verwendet.Das bedeutet:

- Verborgene Schichten: Hier werden Aktivierungsfunktionen verwendet, um nicht-lineare Beziehungen in den Daten zu erkennen.

- Ausgabeschicht: Hier wird die Aktivierungsfunktion oft an die Aufgabe angepasst (z. B. Sigmoid für Klassifizierung oder lineare Funktion für Regression).

Hier sind einige Beispiele für gängige Aktivierungsfunktionen:

- Sigmoid: Wandelt die Eingabe in einen Wert zwischen 0 und 1 um. Wird oft in der Ausgabeschicht für binäre Klassifizierung verwendet.

- ReLU (Rectified Linear Unit): Gibt den Eingabewert zurück, wenn er positiv ist, andernfalls 0. ReLU ist die am häufigsten verwendete Aktivierungsfunktion in verborgenen Schichten.

- Tanh (Hyperbolischer Tangens): Wandelt die Eingabe in einen Wert zwischen -1 und 1 um. Ähnlich wie Sigmoid, aber mit einem symmetrischen Ausgabebereich.

Aktivierungsfunktion im Trainingsprozess

Aktivierungsfunktionen spielen eine wichtige Rolle im Trainingsprozess. Während des Trainings werden die Gewichte des Netzwerks angepasst, um die Vorhersagen zu verbessern. Die Ableitung (eine mathematische Operation, die die Änderungsrate einer Funktion beschreibt) der Aktivierungsfunktion wird verwendet, um diese Anpassungen vorzunehmen.

Zusammenfassung

- Aktivierungsfunktionen führen Nichtlinearität in Neuronale Netzwerke ein.

- Sie sind entscheidend, um komplexe Muster in Daten zu erkennen.

- Gängige Aktivierungsfunktionen sind Sigmoid, ReLU und Tanh.

- Sie spielen eine wichtige Rolle im Trainingsprozess, insbesondere bei der Anpassung der Gewichte.